Kannst du deinen Augen trauen?

Es gibt sie immer häufiger: Bilder, die nur dazu konzipiert sind, uns zu täuschen. Sogenannte Deep Fakes lassen sich immer leichter herstellen und sind immer öfter auf Social-Media-Plattformen zu finden. Wie man Deep Fakes erkennt, wie man vermeiden kann, selbst zu einem Deep Fake zu werden und welche Folgen Deep Fakes für uns haben.

Barack Obama bezeichnet Donald Trump als „Volltrottel“, Lena Meyer-Landrut spielt in einem Porno mit und Joe Biden ruft zur Wiederwahl des US-Präsidenten auf. Das ist in Videos, die inzwischen mit einer einfachen Google Suche gefunden werden können, zu sehen. Sie werden auf Twitter und anderen Social-Media-Kanälen gepostet und verbreiten sich in rasanter Geschwindigkeit.

Einmal als Star auf dem roten Teppich posieren oder in einem bekannten Musikvideo mitspielen. Was zum Spaß mit einem Snapchat- oder Instagram-Filter begann, wird inzwischen immer gefährlicher. Ständig tauchen neue Bilder und Videos auf, die nur dazu da sind, Falschinformationen zu vermitteln. Durch sogenanntes „Machine Learning“ wird es einfacher Deep Fakes zu erstellen.

Die Entwicklung von Künstlicher Intelligenz schreitet unaufhaltsam voran, was immer bessere und beinahe originalgetreue Deep Fakes entstehen lässt. Das führt dazu, dass man immer weniger sagen kann, ob ein Bild oder Video echt ist oder nicht. Das führt bei vielen zu Skepsis und Angst vor Falschinformation.

Doch was sind Deep Fakes überhaupt?

Der Begriff Deep Fake setzt sich aus den beiden englischen Wörtern „Deep Learning“ und „Fake“ zusammen. Es handelt sich um Bildmaterial, das mithilfe Künstlicher Intelligenz hergestellt wird. Dabei können originale Bilder und Videos so weit verändert werden, dass dabei vollkommen neue Videos und Bilder, die so gar nicht existieren entstehen können. Das Endprodukt wirkt dabei weitgehend authentisch und täuschend echt – was es aber nicht ist.

Deep Fakes können verschiedene Motive verfolgen: Sie können zum einen als Kunst- und Anschauungsprojekte geschaffen werden, aber auch zur Manipulation oder Propaganda. Bei letzterem Punkt sind vor allem Politik und Pornografie betroffen.

Wie einfach es inzwischen schon ist, ein Deep Fake zu erstellen, zeigt das folgende Video.

Woran erkennt man ein Deep Fake?

Durch Deep Fakes wird es also deutlich schwerer zu erkennen, ob eine Information Fakt oder Lüge ist. Tano Müller ist Doktorand an der Uni Freiburg und forscht zum Thema Künstliche Intelligenz. Er weiß, woran man Deep Fakes erkennen kann und wie sie wirken.

Tano Müller forscht zum Thema Künstliche Intelligenz.

Hallo Tano, ein Deep Fake ist ein Bild oder ein Video, das mittels Deep Learning Modellen bearbeitet oder erzeugt wurde. Man kann ja Fotos auch mit Photoshop bearbeiten, dann ist es aber noch kein Deep Fake. Ab wann spricht man denn genau von einem Deep Fake?

Sobald ein Bild oder Video durch ein Deep Learning Modell bearbeitet wurde spricht man von einem Deep Fake. Um das abzugrenzen hier ein einfaches Beispiel: Wenn jemand mit Photoshop oder ähnlicher Software ein Bild bearbeitet ist das zwar ein fingiertes Bild, aber kein Deep Fake.

Wir haben in unserem Video schon gezeigt, dass es mit simpler Software aus dem Internet nicht schwer ist, ein einfaches Deep Fake zu erstellen. Doch wie verhält es sich mit der dahinterstehenden Software? Ist es insgesamt schwer zu „deepfaken“?

Je nachdem! Es ist sehr schwer ein Deep Learning Modell selbst zu entwickeln, denn man braucht Wissen über künstliche neuronale Netze und Programmierfähigkeiten. Ein bestehendes Modell anzuwenden, ist allerdings relativ einfach. Es gibt zum Beispiel schon eine App, mit der man Gesichter in fremde Gesichter, zum Beispiel von Promis, einsetzen kann.

Was passiert, wenn ich ein solches Programm, das also einen Deep Fake erstellen kann, benutze?

Das ist deutlich schwerer zu erklären. Man braucht zunächst zwei Netzwerke: Zum einen ein zusammengesetztes, tiefes, neuronales Netzwerk, also ein Modell, welches ein Eingangsbild in eine hochdimensionale Vektorrepräsentation überführt. Diese Zwischenform der Vektorrepräsentation kann man sich nur schwer vorstellen. Sie ist für uns Menschen weder lesbar, noch können wir irgendwas in sie hineininterpretieren. Nachdem das Bild in die Zwischenform transformiert wurde, kommt das zweite Netzwerk zum Einsatz. Diese nimmt die erstellte Vektorrepräsentation und erstellt daraus ein neues Bild.

Das hört sich nach komplexen und komplizierten Vorgängen an. Doch diese sind für uns nicht ersichtlich, wenn wir uns ein Bild anschauen. Kannst du sagen, woran man Deep Fake erkennt?

Das ist bis heute ein offenes Forschungsfeld und kann nicht ganz eindeutig beantwortet werden. Es gibt bestimmte Indikatoren, mit denen man erkennen kann, dass an einem Bild oder Video Veränderungen vorgenommen wurden. Dazu gehören zum Beispiel Pixelartefakte, die man erkennen kann, wenn ein Bereich des Gesamtbildes anders aussieht. Bei gefälschten Videos sieht man dann, dass zum Beispiel eine Person deutlich häufiger, langsamer oder schneller blinzelt.

Wie kann ich mich dann eigentlich davor schützen, dass meine Bilder zu einem Deep Fake gemacht werden?

Das ist für die meisten von uns wahrscheinlich ein Problem, denn der einzig wirksame Schutz ist, keinerlei digitale Bilder oder Videos von sich in Umlauf zu bringen. Diese Deep Learning Modelle sind in der Regel sehr datenhungrig, was bedeutet, dass sie Daten benötigen. Je mehr Daten sie haben, desto besser können sie trainieren und umso besser werden auch die Ergebnisse. Zusammengefasst: Möglichst keine digitalen Bilder oder Videos von sich verfügbar machen und natürlich auch keine Feinde haben, die technisch fit genug sind, so etwas umzusetzen.

Falschmeldungen sind ja schon ein Thema, seit es Berichterstattung gibt. Was sind denn aus deiner Sicht Folgen von Falschinformationen in Bildform?

Alle Folgen, die man auch schon in der Vergangenheit von Fälschungen kennt, allerdings in deutlich stärkerer Form. In der Regel werden sie für Propaganda oder fürs Niedermachen verwendet, das heißt Personen, Firmen oder sogar ganze Länder können diskreditiert werden. Mit diesen Deep Fakes wird das deutlich schwerer erkennbar, wir können zunehmend weniger unterscheiden, ob diese Information richtig oder falsch ist.

Künstliche Intelligenzen können heutzutage ja bereits völlig autonom Bilder fälschen.

Ja, nachdem ein Modell trainiert wurde, kann man das Modell theoretisch automatisiert mit Bildern füttern. Um ein sinnvolles Szenario zu erstellen, sollte man jedoch mindestens noch eine Person haben, die zum Schluss den Befehl gibt und sagt: „Liebes Modell, nimm doch dieses Bild und generiere mir ein Neues daraus.“

Was wird sich in den kommenden Jahren auf diesem Gebiet noch entwickeln?

In den nächsten Jahren wird es sicher noch mehr Fake News geben, um Menschen in eine bestimmte Richtung zu lenken. Doch mittlerweile gibt es schon ganze Teams, die versuchen gegen Deep Fakes vorzugehen. So haben sich einige Firmen und Forschungsprojekt zusammengeschlossen, um gezielt herauszufinden, wie man Deep Fakes unter echten Bildern und Videos erkennen kann.

Wird es in Zukunft Software geben, die Fälschungen erkennen kann und wenn nicht, kann man dann Fotos oder Videos überhaupt noch als Beweismittel trauen?

Zuverlässig wird es wohl keine Software geben, die Deep Fakes erkennen kann. Auch wenn man annimmt, dass es ein Mittel gäbe, mit dem man Deep Fakes erkennt, würden die Leute, die Deep Fakes erstellen, daraus lernen und das Verfahren verbessen. Aktuell sind Deep Fakes immer mindestens einen Schritt voraus, im Vergleich zu Erkennungsverfahren. Das heißt, dass man jedes digitale Video und Bild, eigentlich in Bezug auf die Validität anzweifeln muss.

Deep Fake – kannst du deinen Augen trauen?

Deep Fakes werden also immer schneller und öfter produziert. Doch welche Folgen hat das für unsere Gesellschaft? Wir haben uns mit verschiedenen Experten unterhalten und sie nach ihrer Meinung zu Deep Fakes befragt. Was dabei herausgekommen ist und welche Folgen Deep Fakes haben, erfahrt ihr in unserem Podcast.

Eine Gemeinschaftsproduktion von Myriam Wetter, Laura Schenk und Jonas Vogele im Rahmen des Seminars „Einführung in den crossmedialen Journalismus“ für Studierende der Medienkulturwissenschaft.

Seminarleitung, Redaktion: Silvia Cavallucci, Karsten Kurowski, Ada Rhode.

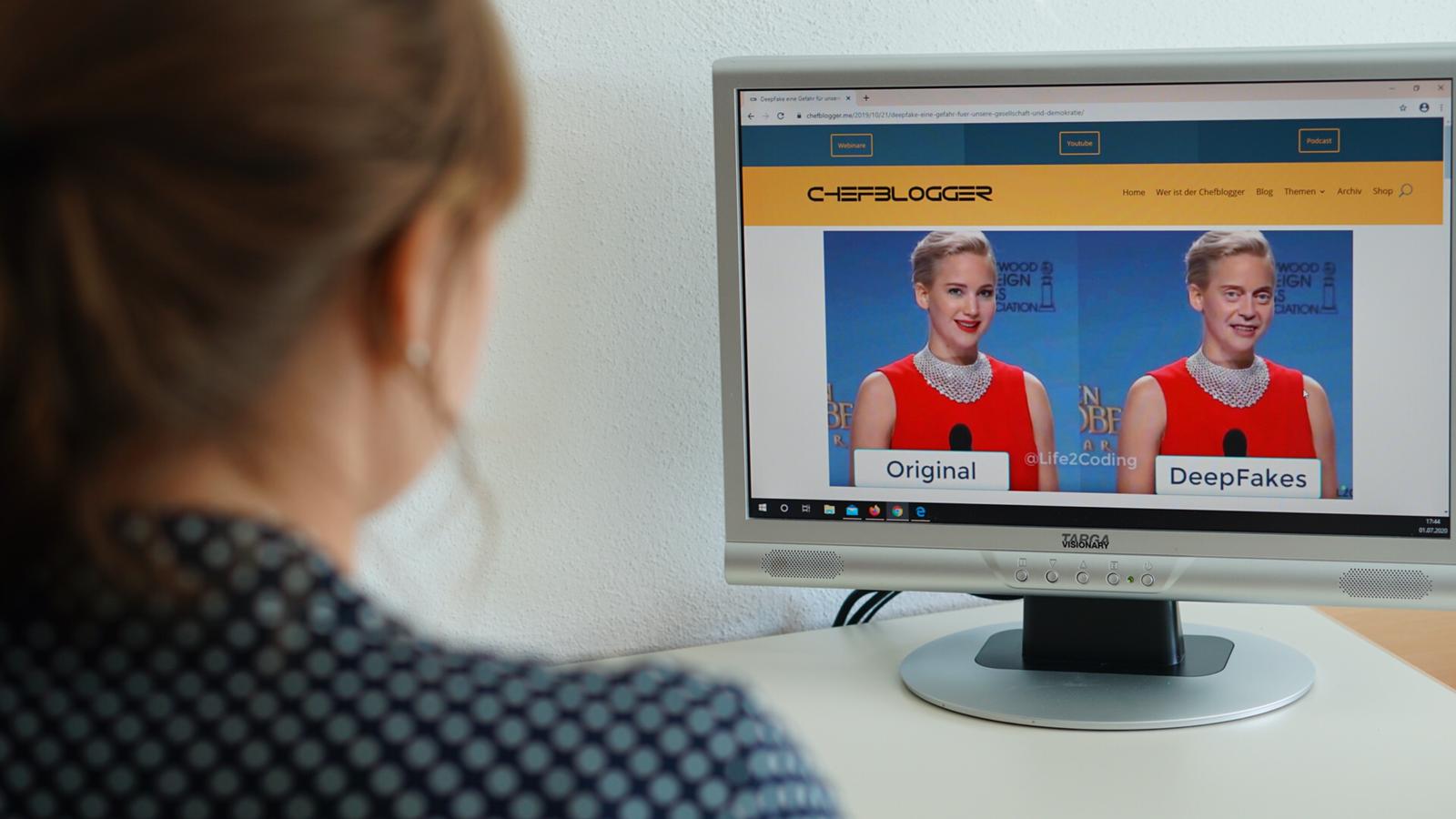

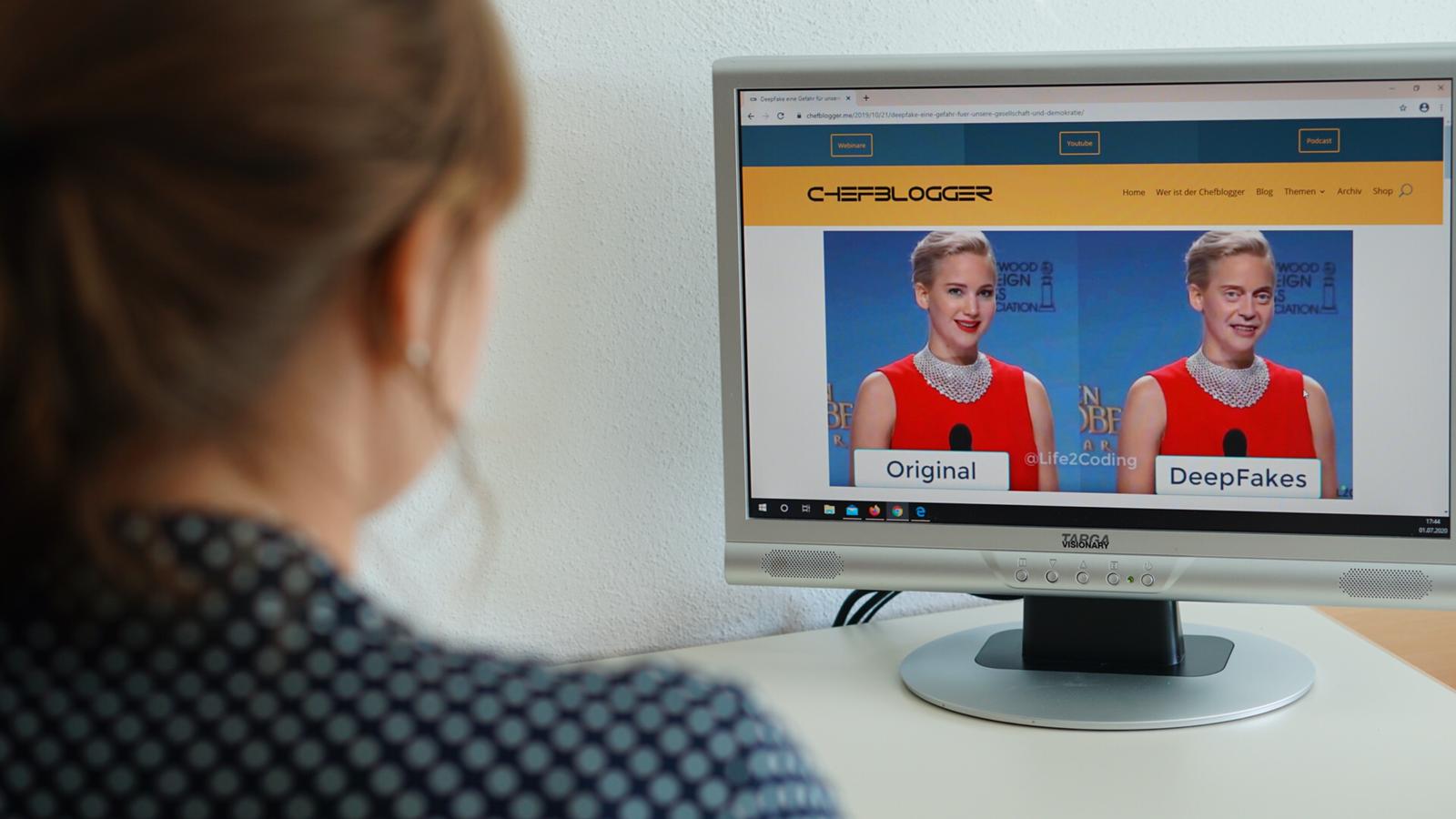

Hinweis zum Foto

Auf diesem Bild werden zwei Screenshots eines Videos miteinander verglichen. Dabei ist im Originalbild, links, Jennifer Lawrence zu sehen und das rechte Bild zeigt das gefakte Endprodukt. Die Echtheit des Deep Fakes wird dadurch gerechtfertigt, da es einem gefakten YouTube Video entnommen ist, welches weiter unten auf derselben Seite verlinkt ist. Bei Interesse kann man sich dieses Video anschauen, da es einen sehr extremen Deep Fake zeigt.